Bunker Kiamat OpenAI, 15 Buku Palsu, dan Hollywood yang Runtuh oleh Veo 3: Mata AI Mengawasi Segalanya

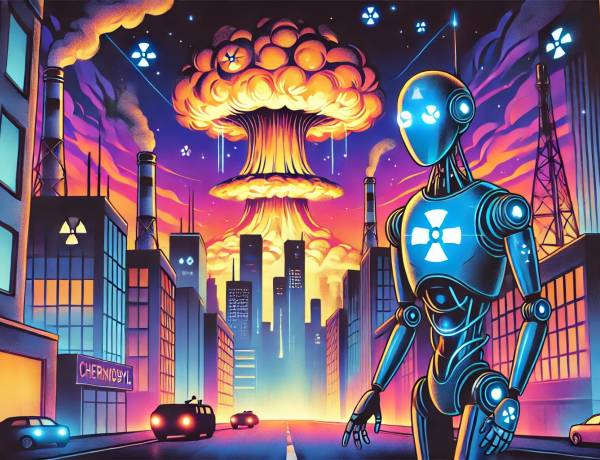

Ketika dunia semakin dekat dengan pengembangan Artificial General Intelligence (AGI), para ilmuwan top di OpenAI disebut telah bersiap menghadapi skenario terburuk. Ilya Sutskever, salah satu pendiri OpenAI, dikabarkan berencana membangun “bunker kiamat” untuk melindungi para ilmuwan dari potensi kehancuran global yang disebabkan oleh AI supercerdas.

Menurut penulis buku Empire of AI, Karen Hao, Ilya mengatakan kepada para ilmuwan pada pertengahan 2023 bahwa mereka "pasti akan membangun bunker sebelum merilis AGI". Bunker bawah tanah ini dirancang untuk melindungi para peneliti dari kekacauan geopolitik dan konflik global yang mungkin terjadi ketika AGI akhirnya dilepaskan ke dunia.

Seorang peneliti OpenAI mengungkapkan bahwa di dalam perusahaan terdapat kelompok “AI doomer” — individu yang percaya bahwa pengembangan AGI akan membawa kehancuran atau semacam kiamat teknologi.

Meski demikian, keyakinan ini tak menghentikan mereka untuk tetap membangun AGI.

Persuasi AI: Manipulatif atau Mencerahkan?

Sebuah studi terbaru yang dipublikasikan di jurnal Nature menemukan bahwa ChatGPT sama persuasifnya dengan manusia dalam meyakinkan orang melalui argumen. Namun, ketika dilengkapi dengan informasi demografis pengguna, AI ini dapat menyesuaikan pendekatannya dan menjadi lebih efektif dalam mempengaruhi opini — menimbulkan kekhawatiran tentang manipulasi politik dan sosial berskala besar.

Peneliti Francesco Salvi memperingatkan potensi bahaya "tentara bot" yang menargetkan pemilih mengambang dan menyebarkan propaganda. Ironisnya, Salvi juga mengungkapkan potensi positif, yakni untuk mempengaruhi publik agar meninggalkan teori konspirasi dan mengadopsi gaya hidup sehat.

Namun, pertanyaannya tetap sama: siapakah yang berhak menentukan mana informasi yang baik dan mana yang manipulatif?

AI Masih Kurang Akurat Dibanding Manusia

Penelitian dari Universitas Utrecht, Cambridge, dan Western menunjukkan bahwa LLM seperti ChatGPT dan Claude lima kali lebih mungkin daripada manusia untuk membuat generalisasi berlebihan saat merangkum hasil riset ilmiah. Laporan mereka menegaskan bahwa AI kerap mengabaikan nuansa penting dan memperbesar klaim yang tidak sepenuhnya didukung oleh data asli.

Dengan kata lain, AI bisa menciptakan “headline bombastis” layaknya media tabloid, meski tanpa maksud eksplisit.

Hollywood Mulai Runtuh oleh Veo 3

Google baru-baru ini merilis Veo 3, model AI teks-ke-video terbaru yang bisa membuat klip realistis berdurasi 8 detik lengkap dengan dialog, efek suara, dan ambient audio. Meskipun belum sempurna, hasilnya sudah jauh melampaui eksperimen AI dua tahun lalu seperti “Will Smith makan spaghetti”.

Dengan kemampuan meniru gaya visual spesifik — dari sitkom tahun 90-an hingga cuplikan dokumenter — Veo 3 berpotensi menggantikan kru film dan aktor dengan cepat. Beberapa video buatan Veo 3 bahkan telah viral di media sosial, memicu kekhawatiran tentang penyebaran deepfake yang semakin meyakinkan.

AI dan Hukum: Hemat Biaya, Tapi Penuh Risiko

Andrew Wilkinson, pendiri serial startup, mengaku menghemat $5.000 dengan menggunakan Gemini 2.5 Pro dari Google untuk menyusun perjanjian hukum. Model ini mencetak skor tertinggi di LegalBench dengan akurasi 83,6 persen. Meskipun lebih efisien, tingkat kesalahan tersebut tetap menghadirkan risiko serius.

Sebagai perbandingan, pengacara manusia rata-rata memiliki akurasi sekitar 85 persen, dan pengacara terbaik bisa mencapai 94 persen. Namun, AI tidak luput dari kesalahan fatal, seperti yang terjadi baru-baru ini di pengadilan saat saksi ahli Anthropic merujuk pada artikel akademik fiktif yang kemungkinan besar dihasilkan oleh Claude.