AI Tidak Butuh Model Lebih Besar, Tapi Data Manusia yang Lebih Baik

Kecerdasan buatan (AI) tidak akan berarti tanpa keterlibatan manusia dalam pengelolaan data dan praktik pelatihan yang tepat. Meskipun proyeksi pertumbuhannya sangat besar, inovasi AI akan kehilangan relevansi jika terus dilatih dengan data berkualitas buruk.

Selain meningkatkan standar data, model AI juga memerlukan intervensi manusia untuk pemahaman kontekstual dan pemikiran kritis demi menjamin keluaran yang akurat serta perkembangan AI yang etis.

Masalah Utama AI: Data Buruk

Manusia memiliki kesadaran yang bernuansa dan kemampuan mengambil keputusan berdasarkan pengalaman. Sebaliknya, model AI hanya sebaik data pelatihannya.

Akurasi AI tidak hanya bergantung pada kecanggihan algoritma atau volume data yang diproses, tetapi pada kualitas dan keandalan data pelatihan serta uji performa analitiknya.

Data yang buruk menyebabkan berbagai masalah serius: menghasilkan output bias, halusinasi dari logika salah, dan membuang waktu untuk melatih ulang model guna "menghapus" kebiasaan buruk—yang pada akhirnya meningkatkan biaya operasional.

Kasus seperti kesalahan identifikasi oleh AI pengenal wajah, sebagaimana dilaporkan oleh Innocence Project dan diakui mantan kepala polisi Detroit, membuktikan bahwa 96% hasilnya bisa salah jika hanya mengandalkan AI. Harvard Medical School juga mengungkapkan diskriminasi algoritmik di sistem kesehatan AS yang memprioritaskan pasien kulit putih lebih sehat dibanding pasien kulit hitam yang lebih sakit.

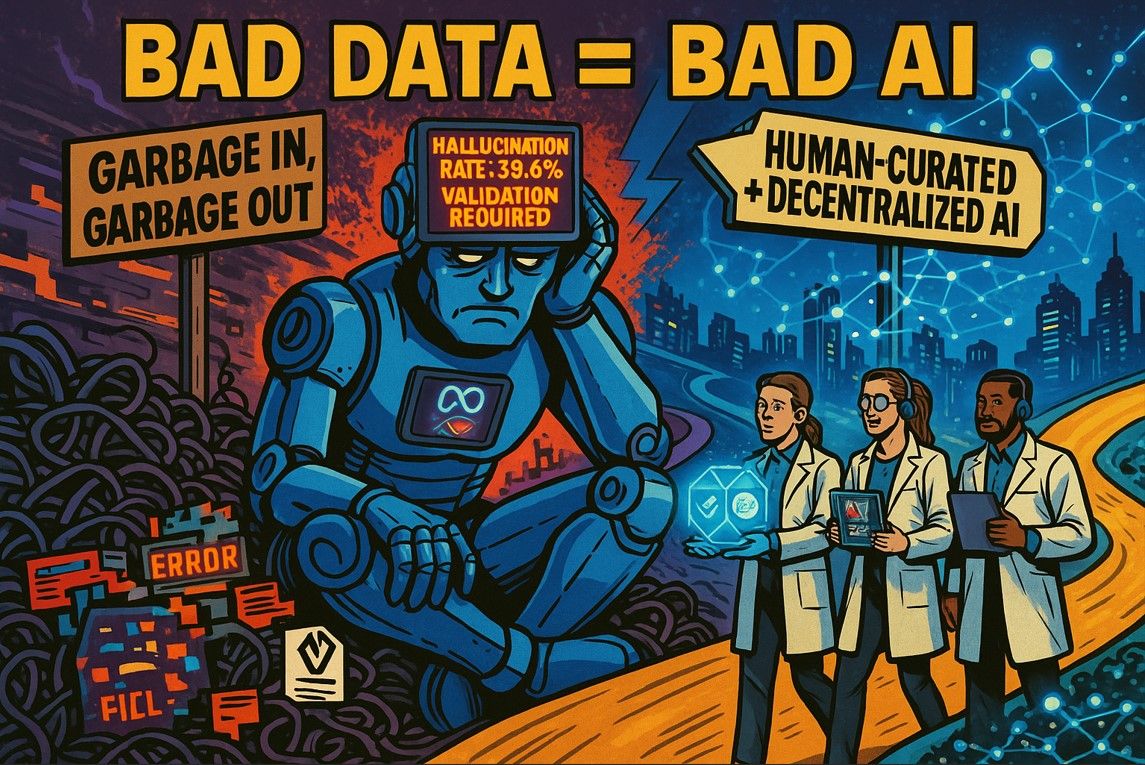

Fenomena “Garbage In, Garbage Out” (GIGO) kembali relevan: data masukan yang cacat akan menghasilkan output berkualitas rendah, menciptakan inefisiensi dan memperlambat pelatihan ulang model.

Lebih dari itu, data buruk mengikis kepercayaan korporasi terhadap AI. Laporan menyebutkan bahwa GPT-3.5 mengalami tingkat halusinasi sebesar 39,6%, memperlihatkan urgensi validasi manusia dalam sistem AI.

Dalam survei CIO Network Summit, 21% pemimpin IT top di AS menyebutkan kurangnya keandalan sebagai alasan utama mereka enggan menerapkan AI.

Rata-rata, data pelatihan yang tidak lengkap dan berkualitas rendah menyebabkan keputusan yang salah dan menelan kerugian hingga 6% dari pendapatan tahunan perusahaan.

Manusia Masih Menjadi Faktor Kunci

Akibat dari masalah ini, perusahaan AI banyak mengalihkan tenaga ilmuwan data mereka untuk fokus mempersiapkan set data yang benar. Sebanyak 67% waktu ilmuwan data dihabiskan untuk proses ini demi menghindari kesalahan output AI.

Tanpa ahli manusia yang menyempurnakan model, AI akan kesulitan menghasilkan keluaran yang relevan. Ini menegaskan pentingnya keterlibatan manusia dalam kurasi data yang akurat dan dapat dipercaya.

Pernyataan Elon Musk bahwa AI telah “menguras pengetahuan manusia” dalam pelatihan sangat menyesatkan. Justru, data frontier manusia adalah kunci untuk membangun model AI yang lebih kuat, adil, dan andal.

Data sintetis tidak mampu menggantikan intuisi dan pengalaman manusia yang dibutuhkan untuk pengambilan keputusan etis. Oleh karena itu, kurasi dan validasi data oleh manusia sangat penting untuk menjaga konsistensi dan akurasi model.

Solusi: Pendekatan Kolaboratif & Desentralisasi

Pendekatan kolaboratif antara AI dan manusia membantu mengaktifkan intuisi dan kreativitas untuk membangun arsitektur AI baru yang lebih aman dan bermanfaat secara sosial.

Salah satu terobosan yang sedang dikembangkan adalah pembelajaran penguatan dari umpan balik manusia (Reinforcement Learning from Human Feedback / RLHF) berbasis desentralisasi.

Dalam pendekatan ini, siapa pun—baik pengguna umum maupun spesialis domain—dapat berkontribusi dalam pelatihan model AI, dan mendapat kompensasi atas kontribusinya, misalnya lewat anotasi, labeling, dan klasifikasi yang akurat.

Dengan dukungan blockchain, sistem insentif terotomatisasi bisa dibangun agar penghargaan diberikan berdasarkan dampak langsung terhadap peningkatan kualitas model, bukan sekadar kuota atau target.

Desentralisasi ini membantu mengurangi bias struktural dan meningkatkan kecerdasan umum AI dengan melibatkan komunitas global dari latar belakang yang beragam.

Tantangan dan Arah ke Depan

Menurut survei Gartner, 60% proyek AI akan ditinggalkan pada 2026 karena tidak tersedianya data yang siap dilatih. Artinya, kapasitas manusia dalam menyiapkan data pelatihan berkualitas menjadi faktor penentu apakah AI dapat menyumbang $15,7 triliun terhadap ekonomi global pada 2030.

Infrastruktur data AI harus terus diperbarui seiring munculnya kasus penggunaan baru. Manusia diperlukan untuk memantau metadata, mengawasi kualitas data, dan memastikan tata kelola yang baik.

Tanpa pengawasan manusia, perusahaan akan kesulitan menangani volume data masif yang tersebar di berbagai penyimpanan. Pendekatan “human-in-the-loop” menjadi kunci membangun AI yang akurat, relevan, dan siap digunakan secara luas.